En este planteamiento tomaremos las 38 características de cada muestra con datos de ritmo sinusal (RS) y taquicardia (TV ó TSV) con el fin de poder diferenciar los ejemplos de RS/TV de los ejemplos de RS/TSV. La idea de este planteamiento es que tomando datos con Taquicardias (sin eliminar sus características de Ritmo Sinusal RS), podamos diferenciar entre las Taquicardias Ventriculares (TV) y las Taquicardias Supraventriculares (TSV).

Organizaremos los datos de entrenamiento proporcionados en el fichero "cwaNN.mat" de la siguiente manera, distinguiendo los datos pertenecientes a RS/TV de los datos pertenecientes a RS/TSV. Para ello, etiquetaremos los datos pertenecientes a RS/TV con un '0', y los datos pertenecientes a RS/TSV con un '1':

Nuestras variables independientes o predictoras 'X' serán las caracteristicas tomadas de cada una de las muestras (datos proporcionados en el fichero de casos de entrenamiento), mientras que nuestra variable categórica 'Y' recogerá las etiquetas que hemos establecido para los datos.

Con el fin de poder obtener nuestro objetivo (minimización de la función de coste) de forma mas rápida, podemos normalizar los datos de la siguiente manera:

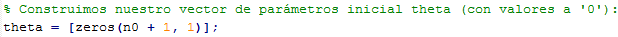

Una vez normalizados los datos, podemos añadir la columna de los valores "X0 = 1" y construir e inicializar nuestro vector de parámetros theta.

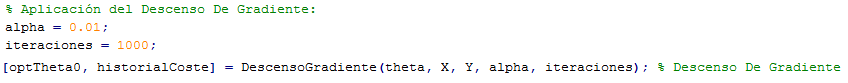

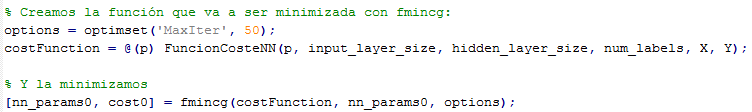

Ahora optimizamos (minimizamos) nuestra función de coste con la funcion "fminunc" de Optimización Avanzada para obtener el valor del vector de parámetros Θ (theta) óptimo.

Una vez tenemos el valor de nuestro vector de parámetros Θ (theta) óptimo, podemos cargar los casos de test, pasárselos a nuestra función Hipótesis de Regresión Logística y evaluar los resultados obtenidos que son los siguientes: